人工智能计算中心:深度智能世界的“激活码”

一百多年前,自激发电机的出现开启了人类的电力时代,但随着技术演进以及电力需求的激增,电机供电的局限性逐渐制约了电力的深度普及。直到1882年,爱迪生在珍珠街建起了第一个中央发电厂,照亮了整个曼哈顿,也揭开了电力时代的新篇章。

一百多年后的今天,人工智能产业正迎来爆炸式发展,作为人工智能产业能源的算力资源,也在应用场景日益复杂化和数据量爆炸式的增长下遭遇瓶颈。

AI算力需求激增, 掀起全球范围算力基础设施竞赛

自1946年第一台计算机诞生以来,算力逐渐成为新的电力,推动人类社会不断从物理世界向数字世界迁移。在此期间,人类对算力的需求不断增长。尤其2012年以后,随着深度学习等算法的突破,AI第一次走进普通人的生活。

一方面,AI的应用场景越来越多,从语音、目标识别,到智慧工厂、智慧城市……乃至战争中的武器。另一方面,AI模型的大小、算法参数也呈几何级增长,鹏城实验室最新发布的“鹏程.盘古”预训练大模型,拥有惊人的2000亿个参数!这样的大模型,以及越来越广泛的应用场景,对AI算力的需求呈现爆炸式的增长。

几年前,谷歌AI负责人杰夫·迪恩(Jeff Dean)曾预言:“我们真正需要的是超过现在100万倍的计算能力,而不仅仅是几十倍的增长。”即便如此大胆的预测,也还是显得太保守。事实上,从2012年到2019年,短短六年间,人类对AI算力的需求增长了30万倍,平均每100天就会翻倍,远超摩尔定律。

与此同时,AI算力的实际增长却有限,需求和供给之间形成一个巨大的鸿沟。

为了填补这个鸿沟,一种新的AI基础设施诞生了,它就是:人工智能计算中心。

在此之前,人类建过许多大型的计算中心。比如,我们熟知的超算中心,集中了一个国家或地区的最强算力,主要用于科研。还有阿里、华为等云厂商兴建的云计算中心,基于云平台,向全社会提供大数据的计算、存储等服务。它们虽然也对外提供AI算力,但毕竟不是主业。而人工智能计算中心专为AI打造,主要用于AI模型的开发、训练和推理,能够为全社会提供AI所需的专用算力。

这种新的AI基础设施,自诞生之日起,就成为全球主要AI大国的角力场。比如,美国投资18亿美金,计划在全国打造三个E级超算,其中一个的算力,超过目前全球十大超算的总和。德国早在2018年就推出国家级人工智能战略,并资助一批高校建设人工智能计算中心。中国也先后建成了深圳鹏城云脑和武汉人工智能计算中心,还有多个城市已开工或者正在筹建人工智能计算中心。

在政府主导下,许多头部企业也纷纷下场。谷歌自研AI专用的TPU芯片,并通过云平台对外输出AI云服务。微软也宣布,斥资10亿美元,构建一个AI计算平台。在中国,阿里投入重金,建立超大规模机器学习平台。而华为,更是鹏城云脑和武汉人工智能计算中心背后的建设主力军。

蓬勃发展的AI产业,无限放大了全社会对算力的需求。为了迈过这道鸿沟,全世界以政府主导、头部企业参建的模式,正掀起一场AI算力的军备竞赛。

“一中心四平台”,人工智能计算中心是AI产业发展的最佳路径

在人工智能计算中心出现前,人们是如何解决AI算力问题的呢?

除了超算中心和云计算中心“兼职”外,更多靠企业自建。例如,谷歌早期就用GPU来加速。后来,为了训练AlphaGo,开发了TPU芯片。但像谷歌这样财大气粗的企业,毕竟是少数。更多的企业,缺乏足够的资金来搭建自己的AI算力。勉强搭起来,算力也有限。而且不同企业的算力,还分散在全国,各自为政。以这样的算力,很难训练出大模型,更别提GPT-3这种超级大模型。而后者,是推动AI技术不断进步、产业不断发展的关键。

未来,AI产业要想大发展,亟需降低算力门槛。而在各地集中建设AI基础设施,也就是人工智能计算中心,不失为一个好的解决方案,可以有效降低AI的算力成本,一改过去AI算力分散的局面。

在地方政府的产业政策引导下,通过集中建设,这种AI基础设施可将算力普惠地输出给全社会,包括企业、科研机构和高校。

过去,训练一个大模型,动辄上千万美元。如今,企业和开发者,可按需租用算力,花小钱办大事,极大地降低了门槛,加速了AI创新。这一点,对于AI产业的繁荣,极为关键。

就像电厂一样,人工智能计算中心首先是一个公共算力服务平台。

但,光有算力还不够。电厂之所以是社会经济的发动机,背后是一个生态,包括上下游产业链、设备厂商和终端用户,等等。因此,人工智能计算中心除了是一个算力服务平台,还是一个AI产业聚集发展平台,能够聚合AI产业链上的各类公司,包括算法公司、数据处理公司、行业集成公司等,形成完整的产业闭环,促进和推动AI产业集群发展。

此外,它还是一个应用创新孵化平台,通过开发者AI创新,与本地优势产业(如制造、医疗、交通、智能电动车等)相结合,让技术转化为产业价值,带动当地产业智能化升级。以武汉为例,库柏特的智能机器人在武汉人工智能计算中心的支持下,通过视觉处理算法创新,其机械臂每次抓取药盒的拍照时间,从过去200毫秒缩短至50毫秒!武汉市政府计划,到2023年孵化60个以上类似的AI深度应用场景,形成AI应用示范项目超过100个。

人工智能计算中心也是一个科研创新和人才培养平台,为将来储备技术和人才。目前,经教育部批准设立AI本科专业的高校已达200余所。有了人工智能计算中心,这些院校可联合行业龙头企业,基于前者充沛的算力,开展技术研发和关键人才的培养。在深圳,鹏城实验室就依托“鹏城云脑Ⅱ”,聚集了31位院士和2000多名科研人员,使得深圳一跃成为国内AI人才高地。

今天的中国,正在打造国家新一代人工智能创新发展试验区。

人工智能计算中心通过“1个中心+4个平台”,形成一个完整的算力生态,彻底打通了“产”“学”“研”“用”全产业链,满足了国家和地方对人工智能产业发展的需求。从这个意义上讲,人工智能计算中心是我国发展人工智能产业的最佳路径。

未来,小到手机、人脸识别,大到无人驾驶、工业机器人……人工智能计算中心将为全社会的智能化,提供源源不断廉价充沛的AI算力,从而托起中国经济的明天。

培育人工智能根技术,夯实我国AI基础设施底座

先行一步的武汉和深圳,已经看到了这种希望。

在武汉,华为助力打造的人工智能计算中心,AI峰值性能可达100PFlops(1P相当于每秒1000万次浮点运算)。在深圳,基于华为Atlas 900集群的“鹏城云脑Ⅱ”可提供世界顶级算力,在最新一期IO500榜单中位居榜首,其全系统输入输出性能得分是排名第二的近20倍。武汉和深圳之外,包括成都在内,全国20多个城市也在积极筹建人工智能计算中心。充沛的算力,给当地乃至全国经济注入了强劲的动力。

从深圳到武汉,再到已开工的成都,中国在兴建人工智能计算中心的路上,再次展现了“基建狂魔”的本色。但同时,我们也要清醒地看到,在这个事关未来的AI基础设施建设上,我们还存在短板。

过去十年,中国在目标识别等AI应用上,领先于世界。可当我们向上捅破天,低下头来建人工智能计算中心时才发现:与西方先进水平相比,自己在AI根技术上还有不小的差距。

电厂的核心是发电机组,人工智能计算中心的核心是芯片。

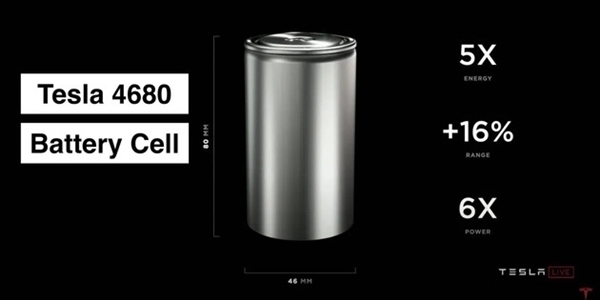

过去,无论超算还是云计算中心,多采用CPU+GPU组合。如今,人工智能计算中心加入了FPGA、NPU等异架构处理器,以多样化算力,加速AI计算。

NPU是一种AI专用芯片,可在电路层模拟人类的神经元和突触。与传统芯片相比,AI算力有数十上百倍的提升。

下图对比了CPU、GPU和TPU(谷歌开发的NPU)的数据处理方式。

NPU的这种大吞吐量,对于需要数据清洗、模型生成、训练和推理的AI计算来讲,优势尤其明显。美国排名第二的打车软件Lyft,自从用了谷歌Cloud TPU,也就是云上AI算力后,以前几天才能干完的活,现在几小时就搞定了。但无论CPU、GPU,还是NPU,国内企业在这些底层芯片上的积累,还比较薄弱。CPU、GPU几乎被英特尔、AMD和英伟达三家公司垄断。NPU相对好一些,华为有昇腾系列,寒武纪也开发了思元系列。

而这,还只是硬件问题。

软件方面,人工智能计算中心是一个算力多样化的平台,如何将众多异架构芯片放在一起还能相互兼容,需要统一的编程框架。当年,英伟达为了将图形处理芯片GPU用在通用计算上,开发了CUDA。如今,华为为了提高开发效率,设计了异构计算架构CANN。

算法是AI的核心。

全世界每天都在产生新的算法和模型,开发者不需要从头学习,但他们需要一个统一的AI算法平台和框架。

目前,全球大多数开发者都选择了谷歌的TensorFlow和Facebook的Pytorch。国内企业最初在这个领域一片空白,后来才有了华为的MindSpore和百度的飞桨,但在开发者人数上,与对手还有不小的差距。有了芯片,有了编程平台和AI框架,再往上,就到了AI应用软件开发平台。在这一层上,国内企业实力不俗,阿里有PAI,华为有ModelArts,百度有AI Studio。开发者们在这些平台上,最终做出赋能千行百业的APP。

AI根技术是AI的基石,只有根深,才能叶茂,才能从底层释放出充沛的算力,支撑起整个顶层应用的全面繁荣。

这种从底层算力释放,到顶层应用使能的AI全栈能力,可以用下图一栏全貌:

从图上可知,谷歌无疑是AI能力最强也最全面的科技公司之一。在国内,拥有类似能力的企业屈指可数,华为算是一家。

作为引领新一轮科技革命和产业变革的战略性技术,人工智能无疑已成为全球大国角力的主战场,并在很大程度上决定着一个国家或地区未来的命运。在我国,人工智能早已上升到国家战略,并在十四五规划中被正式列为前沿科技领域的最高优先级。

道阻且艰,行则将至。各城市人工智能计算中心的陆续落成,无疑让我们向发展为人工智能领域的世界领导者目标又迈出一大步。未来,可期!